# GDELT 介绍

GDELT 是国外一个大数据存储项目,它提供了自 1979 年至今的全球广播、印刷和网络新闻媒体报道的事件,并按时间和位置索引。其数据量十分庞大,类别也很丰富。本篇使用使用 2020 年 6 月 15 日的数据进行试验。

# 下载数据

wget http://data.gdeltproject.org/gdeltv2/20200615000000.export.CSV.zip

# 将数据解压并上传到 HDFS 中

[root@hadoop02 home]# hadoop fs -put 20200615000000.export.CSV /myhome/20200615.tsv

# 开始导入

执行如下的命令,geomesa 的命令行工具会启动一个 MapReduce 任务,将 hdfs 中的数据文件写入到数据库中,并构建索引。

[root@hadoop02 geomesa-hbase_2.11-2.4.1]# geomesa-hbase ingest --catalog <table> --feature-name gdelt --converter gdelt2 --spec gdelt2 "hdfs://hadoop02:9000/myhome/20200615.tsv" |

其中 table 是要写入的表的名称

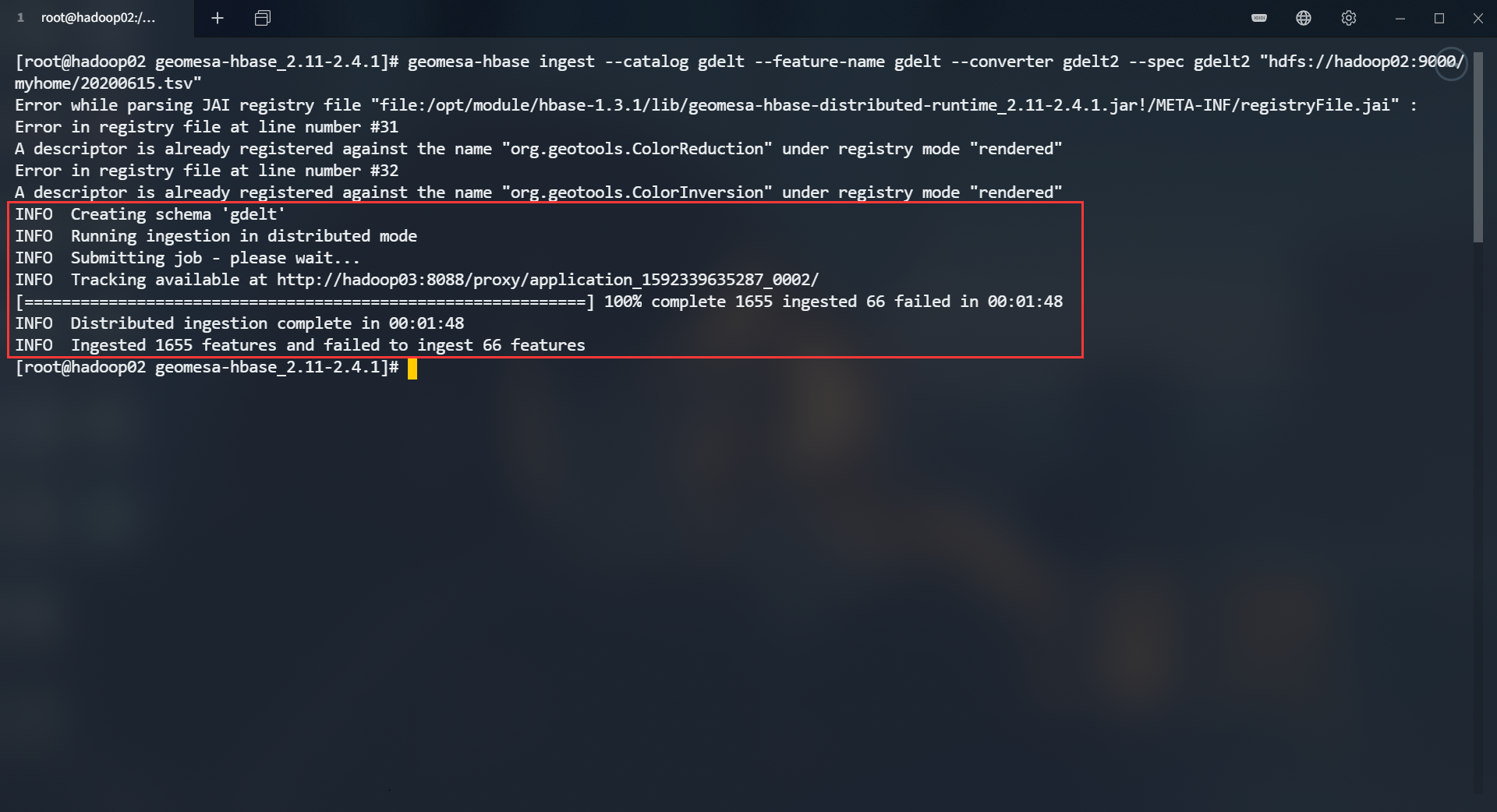

下面是输出结果

可以看到成功导入了 1655 条数据,66 条导入失败。部分失败可能是由于莫名的原因导致的,之后有空再细究吧

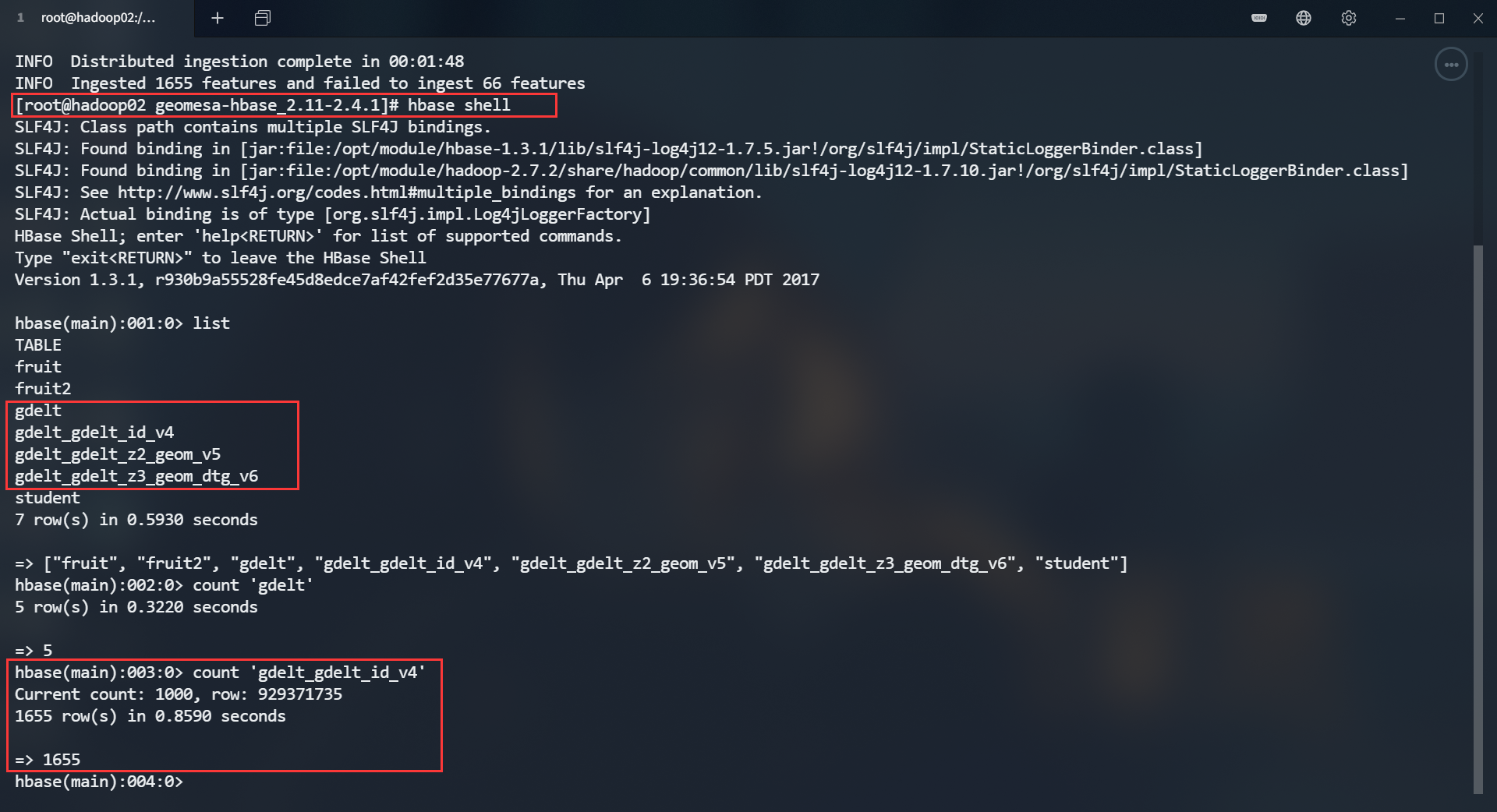

# HBase 查看

可以看到成功导入了 1655 条数据