此帖正在参与 Rokid 活动,如果觉得不错的话,欢迎点赞支持~

帖子链接:https://forum.rokid.com/post/detail/843

可以转载,但请注明出处,谢谢~

应用名称:The Assistant

目标人群:办公人群

应用场景:

功能一:多屏协同办公小助手

当我外出时,比如在高铁上或飞机上,不需要再携带笔记本电脑或 ipad,只需要带一个 Rokid AR 眼镜,搭配用户自己的手机,或 Rokid Station,就可以随时随地拥有多个虚拟屏幕进行办公~

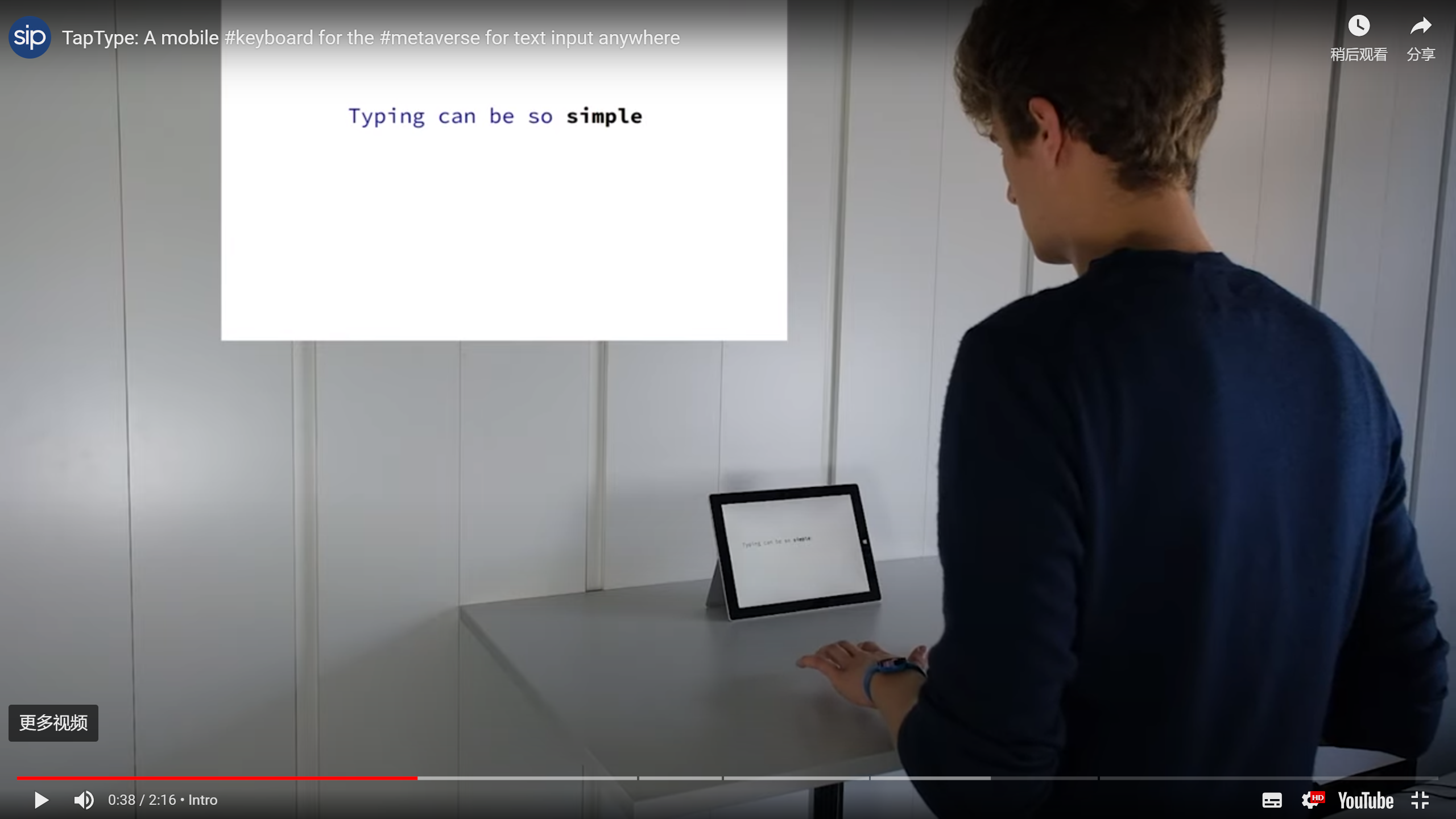

有小伙伴可能会问,虽然不用带笔记本电脑啦,但要办公还是需要鼠标和键盘呀,所以实际上还是不方便嘛。哈哈这个问题我也想过了,一个不错的消息是目前学术界也有一些针对 AR 文本输入的研究。举个栗子,去年苏黎世联邦理工学院 SIPLAB 实验室提出了一个 TapType 技术,用户可以通过佩戴手环实现虚拟文本输入,示意图如下~感兴趣的小伙伴也可以看论文细节:https://siplab.org/research#taptype

因此,笨重繁琐的键盘我相信在未来会被更先进的文本输入技术取代,AR 眼镜都能取代显示屏了,那新技术取代键盘不也是理所当然的事情嘛哈哈

更进一步的话,手势识别,眼动追踪等技术的成熟,我相信也会渐渐取代鼠标的应用~

对了,据说华为 Mate60 系列手机接上 AR 眼镜后,会直接激活电脑模式,有 mate60 系列手机的小伙伴也可以试一下,哈哈

功能二:实时分析小助手

AR 眼镜就是自己的另一双眼睛!当走在大街上的时候,通过摄像头捕获实时音视频流,传输到后端对视频流进行实时分析,实现七龙珠里的战五渣战斗力检测仪不是指日可待吗嘿嘿~

功能三:专家助手

如果有体验过微软 HoloLens2 设备的话,应该会知道 HoloLens2 会提供一个远程专家协助应用,可以和另一个人进行实时音视频通话,对方可以看到自己 AR 眼镜前的场景,并通过手势等标注工具对场景进行标注,实现远程指导等

这个就是很实用的应用,我自己就曾经通过 WebRTC 技术实现了将 HoloLens2 的实时音视频流传输到了 Web 端进行展示,旁观者可以通过看 Web 界面看到我眼镜端的画面,实现了旁观者视角~

所以我觉得未来嘛,想要让专家对自己正在操作的东西进行指导的话,双方直接戴上 AR 眼镜,好,自己操作的东西直接展示在专家眼前了,专家可以直接通过语音,手势等方式,对场景进行标注,标注可以直接实时反映在我面前,再复杂的操作也都能 so easy 啦~